概要

UNetは、セマンティックセグメンテーション(Semantic Segmentation)のタスクにおいて広く使用される畳み込みニューラルネットワーク(Convolutional Neural Network、CNN)のアーキテクチャです。セマンティックセグメンテーションは、画像内の各ピクセルに対して、それがどのクラスに属するかを予測するタスクです。

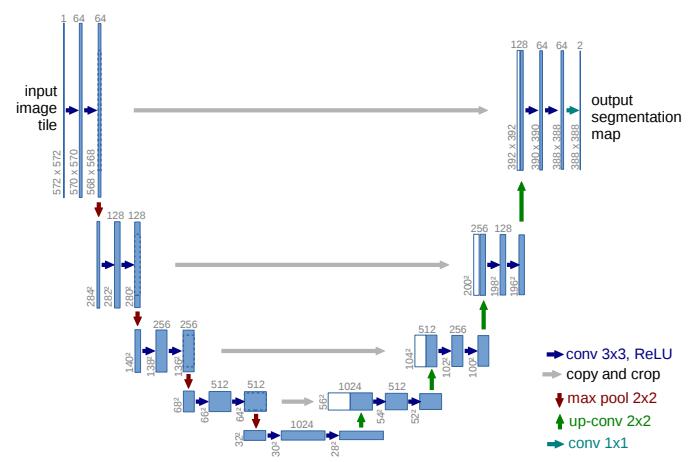

UNetは、2015年に提案されたモデルで、主に医療画像解析の領域で広く利用されています。UNetの特徴的な点は、エンコーダー(Encoder)とデコーダー(Decoder)という2つのパートから構成されるU字型のアーキテクチャです。

エンコーダー部分は、入力画像を低解像度の特徴マップに変換する役割を持ちます。通常、畳み込み層とプーリング層が積み重なったダウンサンプリング(Downsampling)パスで構成されます。エンコーダーは画像のコンテキスト情報を捉え、特徴抽出を行います。

デコーダー部分は、エンコーダーの特徴マップを元の解像度に復元し、ピクセルごとの予測を行います。アップサンプリング(Upsampling)や転置畳み込み(Transposed Convolution)などの手法を使用して、エンコーダーの出力を元の解像度に戻します。デコーダーはエンコーダーからの情報を組み合わせて、詳細な特徴を復元し、セグメンテーションの精度を向上させます。

このU字型の構造により、UNetはローカルな詳細情報とグローバルなコンテキスト情報の両方を組み合わせることができます。セグメンテーションタスクでは、ピクセルごとの分類が重要であり、UNetのアーキテクチャはこのような要件に適しています。

UNetは、医療画像セグメンテーションをはじめとするさまざまな領域で幅広く応用されています。例えば、腫瘍のセグメンテーション、血管の検出、細胞のセグメンテーションなどです。また、UNetのアーキテクチャは拡張や変種が存在し、さまざまな改良が行われています。

コード例

UNetを使用したセマンティックセグメンテーションのためのPythonコードの例を示します。ここでは、TensorFlowライブラリとKeras APIを使用しています。

まず、UNetモデルを定義するための関数を作成します。

from tensorflow.keras.models import Model

from tensorflow.keras.layers import Input, Conv2D, MaxPooling2D, Dropout, concatenate, UpSampling2D

def unet(input_size=(256, 256, 3)):

inputs = Input(input_size)

# エンコーダー

conv1 = Conv2D(64, 3, activation='relu', padding='same')(inputs)

conv1 = Conv2D(64, 3, activation='relu', padding='same')(conv1)

pool1 = MaxPooling2D(pool_size=(2, 2))(conv1)

conv2 = Conv2D(128, 3, activation='relu', padding='same')(pool1)

conv2 = Conv2D(128, 3, activation='relu', padding='same')(conv2)

pool2 = MaxPooling2D(pool_size=(2, 2))(conv2)

conv3 = Conv2D(256, 3, activation='relu', padding='same')(pool2)

conv3 = Conv2D(256, 3, activation='relu', padding='same')(conv3)

pool3 = MaxPooling2D(pool_size=(2, 2))(conv3)

conv4 = Conv2D(512, 3, activation='relu', padding='same')(pool3)

conv4 = Conv2D(512, 3, activation='relu', padding='same')(conv4)

drop4 = Dropout(0.5)(conv4)

pool4 = MaxPooling2D(pool_size=(2, 2))(drop4)

# デコーダー

conv5 = Conv2D(1024, 3, activation='relu', padding='same')(pool4)

conv5 = Conv2D(1024, 3, activation='relu', padding='same')(conv5)

drop5 = Dropout(0.5)(conv5)

up6 = Conv2D(512, 2, activation='relu', padding='same')(UpSampling2D(size=(2, 2))(drop5))

merge6 = concatenate([drop4, up6], axis=3)

conv6 = Conv2D(512, 3, activation='relu', padding='same')(merge6)

conv6 = Conv2D(512, 3, activation='relu', padding='same')(conv6)

up7 = Conv2D(256, 2, activation='relu', padding='same')(UpSampling2D(size=(2, 2))(conv6))

merge7 = concatenate([conv3, up7], axis=3)

conv7 = Conv2D(256, 3, activation='relu', padding='same')(merge7)

conv7 = Conv2D(256, 3, activation='relu', padding='same')(conv7)

up8 = Conv2D(128, 2, activation='relu', padding='same')(UpSampling2D(size=(2, 2))(conv7))

merge8 = concatenate([conv2, up8], axis=3)

conv8 = Conv2D(128, 3, activation='relu', padding='same')(merge8)

conv8 = Conv2D(128, 3, activation='relu', padding='same')(conv8)

up9 = Conv2D(64, 2, activation='relu', padding='same')(UpSampling2D(size=(2, 2))(conv8))

merge9 = concatenate([conv1, up9], axis=3)

conv9 = Conv2D(64, 3, activation='relu', padding='same')(merge9)

conv9 = Conv2D(64, 3, activation='relu', padding='same')(conv9)

outputs = Conv2D(1, 1, activation='sigmoid')(conv9)

model = Model(inputs=inputs, outputs=outputs)

return model

上記のコードでは、エンコーダー部分とデコーダー部分を定義し、それらを組み合わせてUNetモデルを作成しています。エンコーダーでは、畳み込み層とプーリング層を使って特徴マップをダウンサンプリングしています。デコーダーでは、転置畳み込み層と連結操作を使用して特徴マップをアップサンプリングし、元の解像度に戻しています。

次に、UNetモデルを使用してセマンティックセグメンテーションを行うためのコードを示します。

from tensorflow.keras.optimizers import Adam

from tensorflow.keras.losses import BinaryCrossentropy

# UNetモデルのインスタンス化

model = unet(input_size=(256, 256, 3))

# モデルのコンパイル

model.compile(optimizer=Adam(learning_rate=1e-4), loss=BinaryCrossentropy(), metrics=['accuracy'])

# データの準備と学習

train_images = ... # 学習用画像データ

train_masks = ... # 学習用マスクデータ

model.fit(train_images, train_masks, batch_size=4, epochs=10)

# 推論

test_image = ... # テスト用画像データ

predicted_mask = model.predict(test_image)

# マスクの表示など、結果の後処理

...

この例では、UNetモデルを定義した後、モデルのコンパイル、データの準備、学習、推論などのステップが含まれています。具体的なデータの形式やデータの読み込み方法は、セグメンテーションタスクや使用するライブラリによって異なる場合がありますので、適宜変更してください。

また、UNetの改良や拡張版も存在します。上記のコードは基本的なUNetの実装例ですが、さまざまな変種があり、アプリケーションやデータセットに合わせて最適なモデルを選択することも重要です。